En los últimos días se volvió a poner de moda la aplicación FaceApp. Su función es muy simple: te sacás o subís una foto de cara y podés seleccionar verte de otra manera. Después de escanear los patrones faciales la aplicación devuelve una visión estereotipada. Si buscás “cara de mujer”, FaceApp alisa los poros, pronuncia los pómulos y alarga el pelo. Si la selección es “cara de hombre”, suma barba y pone sombreado el mentón.

Para descargar la App rusa hay que aceptar las bases y condiciones y así acceden a tu IP. En potencia pueden ver las páginas que visitaste, cruzar datos y armar un diseño de consumos a tu medida. ¿Visitás calefactores y ponés like en páginas de ecología? Sos posible compradxr de estufas con bioetanol. ¿Estás usando mucho páginas de traducción? ¡Un curso de idiomas es lo que necesitás!

Pero la recopilación de rostros no es solo un tema de publicidad. Las Inteligencias Artificiales se alimentan de datos para poder actuar. Una red neuronal artificial analiza, por ejemplo, millones de imágenes de perros para construir patrones de reconocimiento. Al entregarle las imágenes le decimos “esto es un perro” millones de veces y, luego de analizarla, la inteligencia artificial se considera capaz de decir “esto es un perro”.

https://www.instagram.com/p/CBeSwSwgnUG/?utm_source=ig_web_copy_link%20

En el caso de los rostros la lógica es la misma: analiza millones de caras para detectar y construir patrones. Pero la aplicación es distinta: construyen, por ejemplo, sistemas de reconocimiento facial avanzados, que en términos generales se sienten capaces de decir “esto es una mujer” o “este es un hombre”. O sea: de decidir a qué género pertenecés. Y en ese revuelo de bits, el racismo y el cisexismo offline se replican en la virtualidad.

Esta semana, después de hacer el experimento con Face App, el actor español Paco León –quién interpretó a una mujer trans en La Casa de las Flores– subió el resultado a sus redes sociales.

“Descubres que aunque seas un hombre o una mujer estás en medio de los prototipos de feminidad y de masculinidad”, escribió León. “Como actor he tenido la suerte de poder experimentar con el género pero creo que es interesante para cualquier persona. Tenemos muchos prejuicios culturales y muchos conceptos asociados a lo femenino y lo masculino que convienen ser cuestionados”.

El cambio de género con patrones estereotipados ya fue noticia en 2018, cuando Snapchat habilitó una opción similar. En ese momento varixs referentes de la comunidad trans mundial expusieron una banalización del género a partir de dos o tres patrones groseros y la compañía respondió un comunicado: “Entendemos que la identidad es algo profundamente personal. Nuestro equipo de filtros está explorando las posibilidades de esta tecnología para lograr que sea lo más diversa e inclusiva, proveyendo el mayor espectro posible de efectos”. Entre aquel experimento y el actual las cosas no parecen haber cambiado mucho.

Medir y comparar para construir patrones generalizados no es una pretensión nueva. El “método lombrosiano” medía la estructura de las cabezas y en base a las dimensiones determinaba el grado de criminalidad de una persona. El “Petiso Orejudo”, un asesino serial de comienzos del siglo XX en Argentina, fue analizado y medido pieza por pieza en busca del origen criminal de sus actos.

También hasta mediados del siglo XX hubo corrientes de psicología que afirmaban que la histeria o la homosexualidad podían analizarse a partir de los rasgos, en especial con la nariz, el mentón y las orejas.

Los algoritmos, ¿vendrán a trasladar esa lógica al género? Las personas que no encajen dentro de la norma binarista, ¿serán consideradas una falla?

Reconocer y vigilar

Si los términos generales son esos, los particulares son otros: es muy probable que estemos entregando nuestros datos para la construcción y perfeccionamiento de sistemas de vigilancia de los que no tengamos idea.

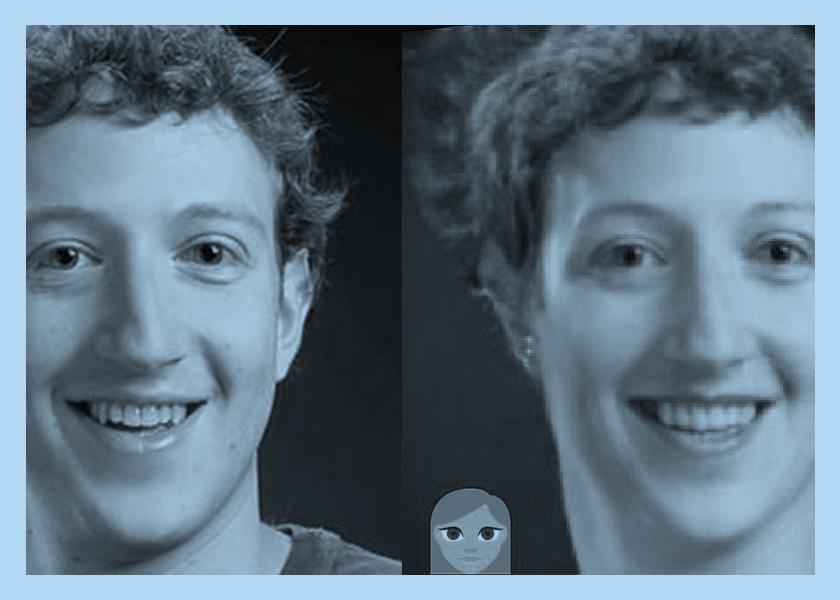

Madre mia el FaceApp pic.twitter.com/ijHjKPvY82

— Historia en Meme (@HistoriaenMeme) June 17, 2020

Las empresas de tecnología acumulan información desde hace años. Facebook, por ejemplo, suele agregarle leyendas alternativas a las fotos. “Aquí probablemente haya un hombre pescando” lee un lector de pantalla para personas ciegas cuando se encuentra con una foto. Lo pueden hacer porque ya analizaron millones y millones de imágenes. Su algoritmo está hiper entrenado por nuestros datos.

Hay empresas que hacen públicos sus experimentos. El año pasado la startup Generated Media –dirigida por el argentino Iván Braun– lanzó un proyecto llamado Generated Photos: 100.000 caras generadas por Inteligencia Artificial para descargar gratis. Para hacerlo dijeron haber usado 29.000 fotografías de 69 modelos. Las imágenes son accesibles en una carpeta de Drive. ¿Impresiona? Técnicamente, esos rostros no existen.

Y si allí se ve el resultado, otras empresas y universidades comparten directamente todo el proceso. En la Universidad de Stanford, por ejemplo, trabajaron con más de 11.000 fotografías tomadas en un café. Como los datos se hicieron públicos, también los usó la National University of Defense Technology in China. Pero la base de datos era muy pequeña: Microsoft llegó a tener una con 10 millones de imágenes.

¿Quién regula todo eso? Una oficina internacional llamada Vetu: ve tú a saber.